Você já se perguntou por que os gráficos dos jogos ficam cada vez mais bonitos, mas exigem placas de vídeo cada vez mais caras e potentes? Pois é.

Uma das grandes vilãs nesse processo é a memória VRAM da GPU, que costuma ser devorada por objetos complexos em 3D, como árvores. Mas a AMD está prestes a mudar esse cenário.

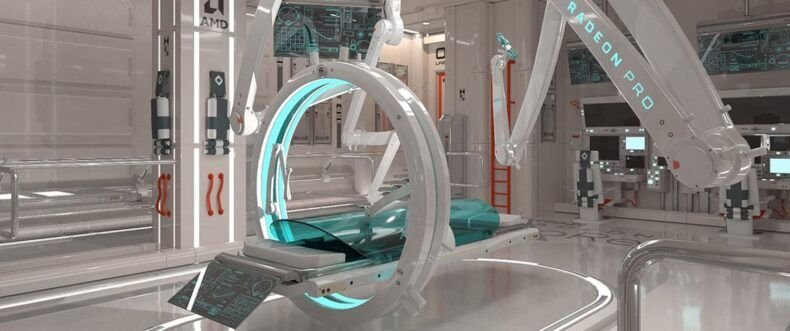

Pesquisadores da AMD desenvolveram uma técnica revolucionária chamada "work graphs". Com ela, conseguiram reduzir drasticamente o uso de VRAM necessário para gerar árvores 3D nos gráficos, que normalmente são muito pesadas.

Só pra você ter uma ideia do impacto, o consumo caiu de 34,8 GB para apenas 51 KB. Isso representa uma redução de até 600.000 vezes.

Por que árvores são um problema?

As árvores em 3D parecem simples à primeira vista, mas por trás das folhas e galhos há muita informação geométrica. Cada folha, tronco e galho precisa ser descrito com precisão para que o visual fique bonito e realista.

Quando essas árvores são criadas por meio de renderização procedural (um método automático e inteligente de gerar gráficos), elas exigem muita memória da GPU.

Aí entra o problema, quanto mais detalhadas as árvores, mais VRAM a placa de vídeo precisa. E esse tipo de memória costuma ser limitado e caro.

A solução da AMD e como funciona

A grande sacada da AMD foi não armazenar toda a estrutura das árvores na VRAM. Em vez disso, eles criaram uma forma de gerar essas árvores em tempo real, usando regras programadas.

É como se a placa de vídeo "soubesse" como montar a árvore a partir de um passo a passo, em vez de guardar a árvore toda pronta. Aí entra o tal do work graph, que é uma espécie de gráfico de tarefas.

Nesse sistema, pequenos pedaços do trabalho são distribuídos entre diferentes partes da GPU, que executam tudo de forma coordenada. A GPU passa a "montar" a árvore conforme o jogo precisa, usando bem menos memória.

Esse método é tipo um "dividir para conquistar", cada pedacinho da GPU faz um trabalho menor, e juntos constroem uma árvore super detalhada, mas sem ocupar espaço à toa.

AMD researcher's real-time GPU tree generation system uses work graphs (w/ mesh nodes) for procedural tree generation. Without work graphs, the trees in the scene would have required 34.8 GiB of VRAM. With work graphs, only 51 KiBhttps://t.co/2YcWdOj5Lehttps://t.co/aDkZB08tks

— Compusemble (@compusemble) June 23, 2025

Como isso se compara com a concorrência?

A NVIDIA, principal concorrente da AMD, também tem suas estratégias. Ela usa algo chamado "mesh shaders", que começou a aparecer com a arquitetura Turing.

Nessa abordagem, o processo de renderização é dividido em duas etapas programáveis, o que dá mais flexibilidade. Além disso, a NVIDIA aposta forte em inteligência artificial, com técnicas de renderização preditiva.

Basicamente, ela cria imagens em baixa resolução e depois usa IA para "aumentar" a qualidade dessas imagens de forma inteligente. Funciona muito bem para quem quer desempenho com gráficos bonitos.

Mesmo que você não seja um especialista em placas de vídeo ou programação gráfica, esse tipo de inovação afeta diretamente a sua experiência em jogos, animações e até aplicativos em 3D. Com essa nova técnica da AMD:

- Jogos podem ficar mais leves, mesmo com gráficos complexos.

- PCs mais simples podem rodar melhor experiências visuais antes limitadas a máquinas caras.

- Desenvolvedores podem criar mundos mais ricos e detalhados sem estourar a memória das GPUs.

E tem mais, como essa solução não depende de novas placas de vídeo, ela pode ser usada em equipamentos que já estão no mercado, desde que o software seja adaptado para isso. A técnica de work graphs ainda não virou padrão na indústria, mas os resultados são promissores.

Com o tempo, é bem possível que ela apareça em jogos e aplicações gráficas modernas, à medida que o público exigir mais qualidade visual sem precisar trocar de hardware o tempo todo.