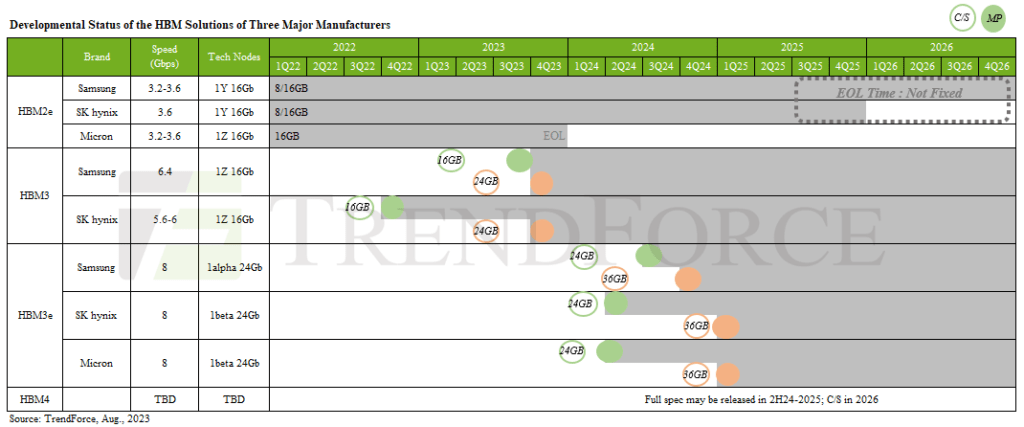

A nova geração de GPUs AI está prestes a revolucionar o mercado com a introdução da tão esperada memória HBM3 com diversas variantes capaz de atender a demanda de todos os fabricantes.

De acordo com os especialistas em tecnologia da TrendForce, líder global de inteligência de mercado nas indústrias de tecnologia, essa avançada tecnologia de memória dominará a indústria de GPUs AI, sendo uma escolha preferencial para muitas empresas que buscam incorporar a DRAM em seus projetos.

Tanto a NVIDIA quanto a AMD já estão preparando suas futuras GPUs AI para aproveitar os benefícios dos designs mais rápidos da memória HBM3.

Atualmente, as placas de vídeo NVIDIA A100 e AMD H100 AI possuem GPUs com memória HBM2e e HBM3, respectivamente, lançadas em 2018 e 2020.

No entanto, grandes players do mercado, como Micron, SK Hynix e Samsung, estão investindo pesadamente no desenvolvimento e produção em massa das novas e mais velozes memórias HBM3, que em breve devem se tornar o novo padrão.

Segundo a TrendForce, os modelos de nível inferior operarão entre 5,6 e 6,4 Gbps, enquanto as variantes mais avançadas ultrapassarão 8 Gbps e serão denominadas "HBM3P, HBM3A, HBM3+ e HBM3 Gen2".

Com a SK Hynix liderando a participação de mercado na indústria HBM, espera-se que suas memórias HBM3 de próxima geração estejam presentes nas futuras GPUs AI, como as GPUs AMD MI300 Instinct e as NVIDIA H100, que, aliás, já demonstraram interesse nessa tecnologia, fazendo solicitações de amostra junto à SK Hynix.

Enquanto isso, a Micron também está trabalhando em seu design de memória HBM4, previsto apenas para 2026, o que significa que as próximas GPUs NVIDIA Blackwell, com o codinome "GB100", muito provavelmente utilizarão as variantes mais rápidas da HBM3 quando forem lançadas entre 2024 e 2025.

A produção em massa da memória HBM3E, que utilizará tecnologia de processo de 5ª geração (10 nm), está prevista para começar no primeiro semestre de 2024, e tanto a Samsung quanto a SK Hynix devem aumentar sua produção.

A concorrência entre os principais players do mercado, como Samsung e Micron, está acelerando, com relatos sugerindo que a Samsung propôs à NVIDIA cuidar da aquisição de wafer e memória por meio de suas divisões.

Ao mesmo tempo, a Micron estaria se associando à TSMC para se tonar um fornecedor de memória para as GPUs AI da NVIDIA e entrar na disputa com outras gigantes do setor.

Há relatos de que os números da TrendForce apontam para um crescimento significativo nas remessas de servidores de IA nos próximos anos, impulsionando uma concorrência saudável entre as empresas.

Essa tendência aumentará o ímpeto para a inovação, beneficiando tanto os fabricantes quanto os consumidores. Assim, a memória HBM3 se apresenta como uma peça-chave nessa evolução, tornando-se o novo padrão em GPUs AI de última geração e prometendo revolucionar o cenário tecnológico.

Via: BusinessKorea, CTEE, TrendForce