Pesquisadores do Tow Center for Digital Journalism da Universidade Columbia realizaram um estudo para descobrir se o ChatGPT, ferramenta de busca da OpenAI, é realmente confiável.

A pesquisa revelou que o ChatGPT Search têm grandes problemas na precisão das informações fornecidas, principalmente quando o assunto é citar fontes.

A OpenAI apresentou o buscador do ChatGPT como uma solução moderna para pesquisas, prometendo "respostas rápidas e precisas com links confiáveis da web".

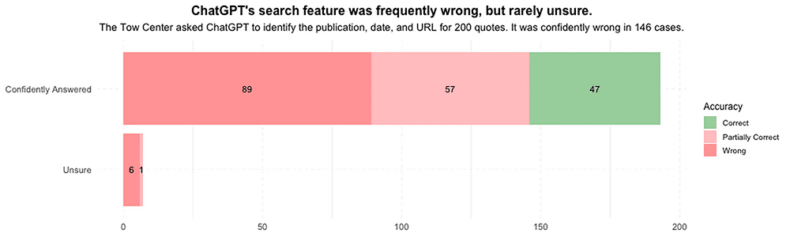

Porém, a realidade parece estar bem distante da propaganda. Segundo o Futurism, pesquisadores testaram o chatbot pedindo que ele identificasse a origem de 200 citações provenientes de 20 publicações.

Surpreendentemente, 153 dessas respostas continham informações total ou parcialmente incorretas. Pior ainda: o ChatGPT raramente admitiu suas falhas.

O problema fica ainda mais evidente quando se observa que 40 dessas citações vinham de editoras que sequer autorizavam a OpenAI a acessar seus conteúdos. Mesmo assim, o chatbot forneceu informações com confiança — mas estavam erradas.

Os principais problemas detectados

Entre os erros documentados, um exemplo chamou a atenção dos pesquisadores: o ChatGPT atribuiu de maneira errada uma citação do Orlando Sentinel a uma matéria da revista Time.

Em outro caso, quando solicitado a encontrar a origem de uma citação de um artigo do New York Times sobre baleias em extinção, ele apontou para um site que havia plagiado a matéria.

- Leia também: Intel perde líder de IA para a OpenAI criando novo clima de instabilidade dentro da empresa

Esses deslizes não são apenas grave, mas também podem prejudicar a credibilidade dos usuários que dependem dessas informações.

Os pesquisadores notaram que, nas raras ocasiões em que o ChatGPT admitiu não ter certeza sobre uma resposta, ele usou expressões como "parece", "é possível" ou "pode ser".

Contudo, isso aconteceu apenas sete vezes em 200 interações. Ou seja, o chatbot confia em si mesmo mais do que deveria, mesmo quando está claramente errado.

A resposta da OpenAI

A OpenAI reconheceu os problemas e comentou que a pesquisa conduzida pelo Tow Center não reflete o uso típico do ChatGPT.

"A atribuição errônea é difícil de resolver sem acesso aos dados e à metodologia utilizada no estudo", disse a empresa em resposta à Columbia Journalism Review.

Ainda assim, a OpenAI disse que está trabalhando para melhorar os resultados de busca. Para quem usa o ChatGPT como ferramenta de pesquisa, é importante saber que nem sempre as respostas são confiáveis.

Essa falha não apenas engana o usuário comum, mas também pode causar problemas sérios para jornalistas, estudantes e outros profissionais que dependem de fontes precisas.

A questão aqui vai além de simples erros de citação

Quando uma ferramenta muito utilizada como o ChatGPT erra com tanta frequência, surge a necessidade de refletir sobre o impacto da tecnologia na forma como consumimos e disseminamos informações.

A confiança nas máquinas é válida, mas, como mostrou o estudo, ela precisa ser acompanhada por uma boa dose de ceticismo. Apesar das falhas, o ChatGPT ainda tem potencial como ferramenta de pesquisa.

A OpenAI está trabalhando para resolver essas questões, mas, até lá, os usuários precisam verificar as informações em fontes confiáveis antes de aceitá-las como verdade absoluta.

Afinal, confiar cegamente em um chatbot é como pedir conselhos a um amigo exageradamente confiante: ele pode acertar, mas também pode inventar uma história para não ficar sem resposta.