A Apple está explorando uma forma de armazenar modelos de linguagem de grande porte (LLMs) em memória flash para trazer essa tecnologia para seus dispositivos móveis e laptops.

Os LLMs são sistemas de Inteligência Artificial (IA) que exigem muitos recursos de processamento e memória, mas a Apple quer torná-los mais acessíveis e eficientes em seus produtos.

Para isso, a Apple está trabalhando em uma técnica que usa os chips de memória flash, que são mais abundantes e baratos do que a memória RAM, para guardar os dados dos modelos de linguagem.

Essa técnica se chama Windowing, e consiste em reaproveitar alguns dos dados que já foram processados pelo modelo, reduzindo a necessidade de buscar constantemente novos dados na memória. Isso torna o processo mais rápido e econômico.

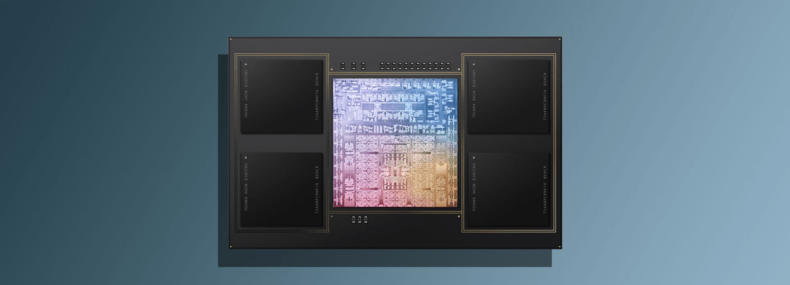

- Leia também: Apple deve adotar design com chiplets nos M5 Pro e M5 Max; Qualcomm ainda não seguiu o mesmo caminho

Além disso, a Apple também está usando outra técnica chamada Row-Column Bundling, que permite agrupar os dados de forma mais eficiente, permitindo que o modelo leia os dados da memória flash mais rapidamente e melhore sua capacidade de compreensão.

Essas técnicas e outras soluções permitem que os modelos de linguagem funcionem até duas vezes o tamanho da memória RAM disponível no iPhone, resultando em um aumento de até cinco vezes na velocidade em processadores padrão e até 25 vezes mais rápido em processadores gráficos.

A Apple já demonstrou seu interesse pela IA, criando seu próprio chatbot, chamado Apple GPT, e melhorando o seu assistente virtual Siri.

Além disso, há rumores de que a próxima versão do iOS, o sistema operacional dos iPhones e iPads, terá algum tipo de IA gerativa, que poderá criar conteúdos originais e personalizados para os usuários.

- Leia também: Apple adia lançamento completo da nova Siri com Gemini e vai liberar recursos aos poucos

Com isso, a Apple pretende se destacar no mercado de Inteligência Artificial, que já conta com grandes nomes como OpenAI, Google, Amazon e outros.

Além disso, ao trazer essa tecnologia para seus dispositivos com memória limitada, a Apple pode oferecer um diferencial para seus clientes, que poderão aproveitar os benefícios dos modelos de linguagem de grande porte em seus aparelhos.

Via: TechPowerUp, Arxiv, Apple Insider